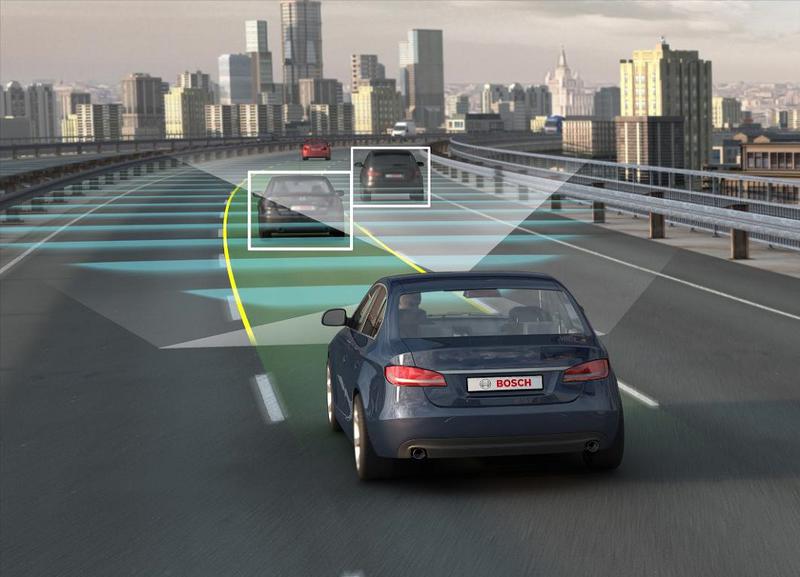

Vor mai trece probabil 25-30 de ani pana cand in jurul nostru vor fi multe masini capabile sa se conduca singure, iar daca aceste masini vor fi 100% sigure, ele ar putea fi puse in fata unui paradox. Ce ar trebui sa faca daca intr-o situatie, intr-o fractiune de secunda, ar trebui sa aleaga intre a lovi un grup de cativa oameni sau a-i evita, insa cu pretul omorarii pasagerului din masina. Cei de la Quartz au pus problema, pornind de un experiment de etica. Din fericire scenariul este unul mai apropiat de filmele SF si va fi intalnit extraordinar de rar in trafic.

Problema de etica este cunoscuta: un tramvai merge necontrolat şi în calea sa se afla cinci persoane care nu pot evita impactul. Insa exista o maneta pe care, daca o actionezi, poti muta tramvaiul pe o alta cale ce l-ar directiona spre o singura persoana. Intrebarea este: ar trebui sa actionezi aceasta maneta pentru a salva cele cinci persoane, omorand insa o persoana.

Daca transpunem problema in lumea masinilor autonome situatia ar fi urmatoarea: masina se indreapta spre un grup de cinci pietoni si singurul mod in care ii poate evita este cazand in prapastie, consecinta fiind ca pasagerul din masina va muri, iar cei cinci pietoni scapa.

Intrebarea este ce decizie ar trebui sa ia masina autonoma. ar trebui sa se conformeze curentului utilitarist care spune ca important e sa fie salvati cat mai multi oameni si atunci cei cinci trebuie sa scape?

Altii spun ca abordarea utilitarista este cruda si ca ar fi culmea ca masina autonoma sa il ucida pe cel din ea, iar astfel de decizii esentiale nu ar trebui niciodata luate de un computer.

Solutia este complicata si trebuie tinut cont si de responsabilitatea morala, nu doar de consecinte. Ar trebui masina programata sa se comporte altfel cand duce de exemplu patru pasageri si risca sa loveasca trei pietoni? `Ar conta daca in masina se afla si copii, in ideea ca viata unui copil ar cantari mai mult decat cea a unui adult?

In plus, masinile autonome, oricat de avansat ar fi soft-ul de pe ele, nu poate judeca intentiile pietonilor si deci nu poate stii daca unul dintre ei nu paseste intentionat in fata masinii.

Insa nu filozofii vor oferi o solutie pentru o astfel de situatie ingrata si nici nu este treaba lor. Din fericire, chiar si dupa 2050, cand drumurile vor fi pline de masini autonome, astfel de situatii vor fi extrem de rare. Iar cand se vor petrece, cu siguranta ca vor exista mai multe variante de iesire din ele, in afara de cele doua variante letale.

In plus, la multe dintre masinile autonome va exista un switch care va permite soferului sa preia instant controlul masinii, iar in zonele in care proprietarul nu are incredere in masina autonoma, va putea sa intervina.